- Published on

AI 工程师成长路线图:系统化学习路径与项目实战

- Authors

- Name

- 俞凡

大多数想要成为 AI 工程师的人都在为错误的目标而学习,花费大量精力学习神经网络、苦练 Kaggle 项目、背诵机器学习理论,而那些真正拿着高薪的 AI 工程师们实际上做着完全不同的事情。

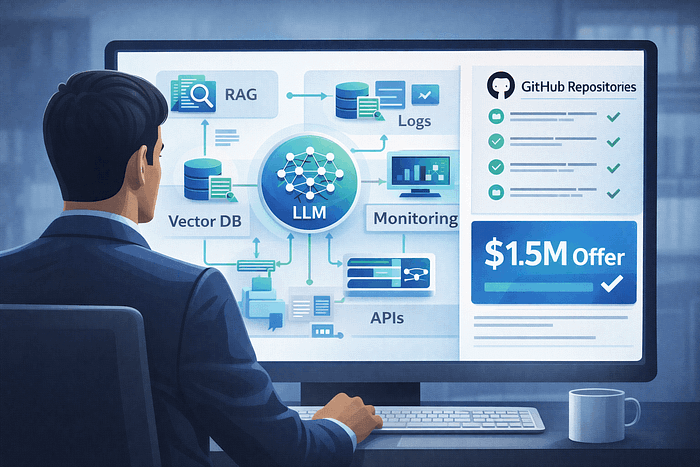

他们正在将 OpenAI、Anthropic 和开源团队的 LLM 集成到真实世界的生产系统中,支撑企业运营,这才是 AI 工程师真正的职业路径。

公司不是招聘 AI 工程师来发明新的 LLM 模型的,而是需要有人能够将 LLM 模型连接到数据库、内部工具、API和工作流,让 AI 能真正完成工作,为公司提供客服机器人、文档处理、分析和自动化服务。

那些拿高薪的人,不是一味追逐研究论文的人,而是那些构建系统的人。

如果想要成为一名有价值的 AI 工程师,需要像一个部署和使用 AI 的系统工程师一样思考,而不是像一个使用 Python 的数据科学家那样思考。

AI 工程师是做什么的?

大多数人听到“AI工程师”时,会想到调整神经网络、修改损失函数,或者在 PyTorch 中运行长达数周的训练任务。相信我,这并不是大多数公司招聘的 AI 工程师职位。

如今的 AI 工程师已经不是人工智能研究者了,研究人员负责发明新引擎,而 AI 工程师负责打造客户使用的系统并保持运行。2026年,大多数真实的 AI 工程职位如下所述:

可以从 OpenAI、Anthropic 或开源项目中获取 LLM,给模型提供上下文,比如公司数据、用户历史、文档,给模型提供工具、数据库、API 和内部系统,然后让模型可靠、安全、高效且快速的工作,并将其部署到人们使用的产品或工作流程中。

2026 年的 AI 工程师角色不再是训练基础模型,而是围绕模型进行工程设计,这意味着 AI 工程师需要:

- 大规模连接模型与数据库

- 将模型连接到内部文档和知识库中

- 集成工单系统、CRM 和支付 API

- 添加护栏、重试和备份逻辑

- 防止 LLM 幻觉、数据泄露以及成本失控

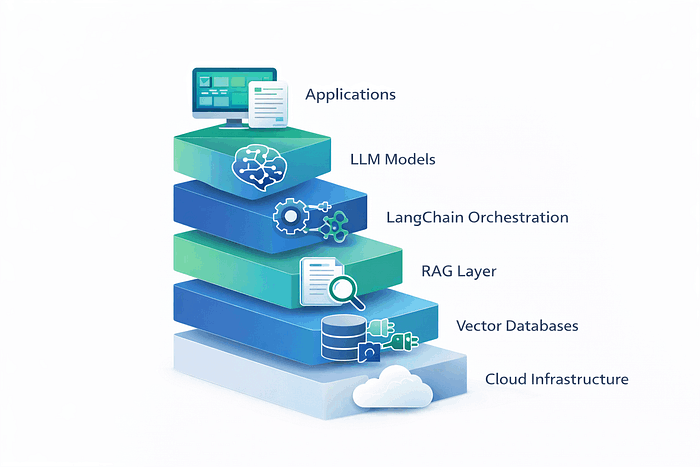

不需要做论文研究实验,而是要运行生产系统。要做到这一点不需要从零开始训练模型,而是需要工程判断、稳健的代码和现实世界的可靠性。如果浏览 2026 年的 AI 工程师招聘信息,会发现同样的 AI 技术栈 会反复出现:

- Python —— 人工智能系统的通用语

- 提示 —— 不是聊天,而是结构化、受控的输入输出设计

- RAG —— 用于真实数据上下文的检索增强生成

- LangChain —— 流水线、工具、内存、编排

- 向量数据库 —— 大规模语义检索

- 云 —— 部署、扩展、监控

公司不需要招聘懂 transformers 工作原理的人,而是要招聘那些懂得如何在真实系统中使 transformers 变得有用的人,正如 Andrew Ng 曾谈及实际 AI 岗位时所说:

“大多数机器学习应用并不涉及从零开始训练模型。”

这一直是他所有课程和演讲中反复出现的主题,包括谷歌提供的免费机器学习速成课程。2026 年,成为 AI 工程师首先需要成为系统构建者,然后再成为模型用户。

2026 年高价值 AI 工程师职业道路

高价值 AI 工程师职位存在的原因与炒作无关,而是源于简单的供需失衡。在需求端,每家大型公司都在试图构建四个系统:

- 内部文档的 AI 搜索

- 为客户和员工提供支持的 AI 代理

- 将原始数据转化为决策的 AI 分析

- 替代人工劳动的 AI 工作流

这些不仅是实验,而是涉及收入、合规和客户体验的运营系统。从技术角度看,这四种都要求采用相同的架构:

- 推理大语言模型

- 基于私人数据的检索系统

- 工具调用内部 API

- 多步骤工作流的编排层

- 监控、记录与访问控制

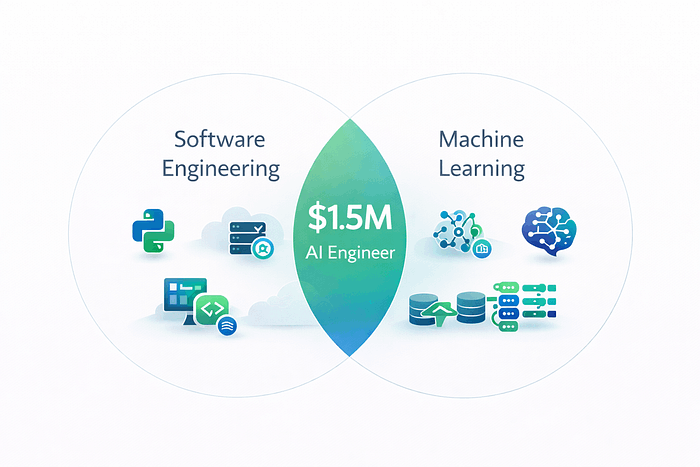

与其说是研究,不如说是大规模产品化工程。现在我们看看供应端,大多数开发者大致分为两类。

其中一类懂软件:

- API

- 数据库

- 云

- 分布式系统

但他们不明白:

- 嵌入

- 上下文窗口

- 提示控制

- 模型行为

另一组懂机器学习:

- 模型

- 训练

- 评估

但他们不知道:

- 如何部署

- 如何扩展

- 如何与真实业务系统集成

很少有人同时知道这两者,这就是为什么公司愿意为综合技能支付溢价。当一家公司构建 AI 支持代理时,并不是在购买模型,而是在购买:

- 文档导入流水线

- 向量搜索基础设施

- API 网关

- 权限系统

- 记录与监测

- 备份与安全逻辑

一个故障的 AI 系统可能让公司损失数百万,所以当一家公司找到一个能够从模型到生产全栈能力的工程师时,并不是在为一行代码而招聘,而是为了业务成果。这也是为什么 AI 应用工程师增长速度快于研究岗位,以及为什么最优秀的工程师在 2026 年能拿到极高的薪资。

一方面,有公司花费数百万美元试图将 AI 接入其核心系统。另一方面,有些开发者要么懂软件,要么懂机器学习,但几乎不可能两者都懂得,并且能在生产环境中工作,这就使得具有综合能力的 AI 工程师拥有极高的溢价。

问题是大多数 AI 工程师的学习路径并不会告诉你如何达到那个目标,它们要么让你深入机器学习理论,要么让你只能做普通软件,再加上一点 AI。所以,与其再给一个模糊的路线图,不如说说我认为 2026 年顶尖 AI 工程师的实际路径。不论年龄或学位,只看先学什么、接下来要建立什么,以及掌握什么才能跻身市场顶端。路线图分为四个清晰的阶段。

第一阶段:掌握基础知识(第1-2个月)

目标:理解 LLM 实际工作原理和控制其行为的因素和方式

i. 面向生产环境的 Python 技能

Python 熟练度是排名第一的 GenAI 需求技能,你需要能够熟练处理:

- API 调用和异步操作

- JSON 处理和数据结构

- 错误处理和重试

- 环境管理

推荐免费教学资源:

CS50 哈佛大学 Python 导论 https://cs50.harvard.edu/python/

谷歌的 Python 课程 https://developers.google.com/edu/python

练习内容:

- 从 API 拉取数据并写入 CSV 的 GitHub 仓库

- 使用 argparse 的 CLI 工具

- 从 .env 文件加载密钥并干净处理错误的脚本

如果能做到这三点,已经领先于大多数自称 AI 工程师的人。

ii. Git 和 GitHub

如果不会 Git,就无法在真正的团队中工作。你应该能够:

- 创建仓库

- 提交变更

- 创建功能分支

- 安全的进行合并

- 打开并审核 pull request

推荐免费教学资源:

Pro Git,官方 Git 书 https://git-scm.com/book/en/v2

GitHub 学习实验室 https://lab.github.com/

沉浸式 Git https://gitimmersion.com/

练习内容:

- fork 一个真正的开源项目并提交 pull request

- 自己运行一个带有 issue 和里程碑的仓库

- 创建特性分支并合并

iii. 掌握机器学习词汇

不需要成为数据科学家,但需要理解模型的语言,否则 API、论文和文档都会变得像噪音一样。你必须明白:

- 训练与推理

- 嵌入是什么

- 令牌和上下文窗口的含义

- 何谓损失与准确度衡量

- 模型实际输出的是什么

这不是可选项,而是避免构建出有问题的 AI 系统的方法。

推荐免费教学资源:

谷歌机器学习速成课程 https://developers.google.com/machine-learning/crash-course

fast.ai 实用机器学习 https://course18.fast.ai/ml.html

Distill https://distill.pub/

练习内容:

- 用 Scikit Learn 训练一个微型分类器

- 生成嵌入并计算相似性

- 用 Hugging Face 分词句子并检查词元

学完这些就不会觉得模型像魔法一样了。

iv. LLM API:公司唯一关心的部分

真正的 AI 工程是 API 工程,必须了解以下内容:

- 发送请求

- 处理速率限制

- 处理 token 限制

- 重试部分失败

- 解析结构化响应

应该学习一个托管 API 和一个开源栈,因为托管模型部署起来更快。

推荐免费教学资源:

OpenAI API https://platform.openai.com/docs/quickstart

Anthropic Claude API https://docs.anthropic.com/claude

这些能为你提供:

- 强模型

- 零基础设施

- 基于使用量的定价

开源模型

能为你提供:

- 成本控制

- 数据隐私

- 本地部署

HuggingFace 是最快的入门方式,有一些参考资源可以帮助你学习:

HuggingFace 课程 https://huggingface.co/course/chapter1

HuggingFace 推理 API https://huggingface.co/docs/api-inference/index

如果能同时使用封闭和开放模型,你就会变得更为不可替代。

v. LLM 参数理解

理解参数不是高级知识 —— 而是基础。

Temperature(温度):

- 控制输出的随机性

- Temperature 0 = 确定性输出(数据提取、分类)

- Temperature 0.7-0.9 = 创造性输出(内容生成、头脑风暴)

- 在 temperature 为 0 时,贪婪采样选择概率最高的词,产生确定性且专注的输出,非常适合需要事实准确性的任务

Top_p和Top_k:

- 控制词汇选择的多样性

- Top_p使用累积概率(更灵活)

- Top_k限制在前K个候选词(更严格)

Max_tokens(最大令牌数):

- 限制响应长度

- 直接影响成本

- 在生产环境中,每个令牌都等于金钱

**为什么这很重要:**在生产环境中,我曾看到一个团队因为 temperature 设置为 0.8,在单个摘要任务上一天就花费了 500 美元,因为生成了不必要的冗长、多样化的响应。将 temperature 调整为0.3,可以让 token 使用量减少 60%。

推荐免费教学资源:

OpenAI API文档 https://github.com/openai/openai-openapi

Anthropic Claude 文档 https://platform.claude.com/docs/en/home

vi. 提示工程基础

自然语言提示工程和检索增强生成(Retrieval-Augmented Generation, RAG)技能对于使用 LLM 的软件工程师至关重要。

零样本提示:

- 模型在没有示例的情况下响应的最简单方法

- 在任务简单时效果很好

- 适合测试基线能力

少样本提示:

- 展示特定示例以突出任务复杂性

- 引导模型朝向期望的行为

- 对于复杂或特定领域的任务至关重要

思维链:

- 将复杂任务分解为更简单的步骤

- 引导模型产生更好的最终输出

- 对于推理任务至关重要

结构化输出:

- 获得一致的JSON、XML或格式化响应

- 对于生产集成必不可少

- 需要仔细的提示设计

推荐免费教学资源:

- ChatGPT 提示工程(DeepLearning.AI)https://learn.deeplearning.ai/courses/chatgpt-prompt-eng/lesson/dfbds/introduction

- DAIR.AI 提示工程指南 https://www.promptingguide.ai/

- OpenAI 官方提示工程指南 https://platform.openai.com/docs/guides/prompt-engineering

- Microsoft 提示工程指南 https://learn.microsoft.com/en-us/azure/ai-services/openai/concepts/prompt-engineering

- Anthropic 提示设计指南 https://platform.claude.com/docs/en/build-with-claude/prompt-engineering/overview

练习内容:

- 强制模型返回有效的 JSON

- 将用户意图分类为固定标签

- 在严格长度限制下总结文本

当模型输出不符合格式时,不是责怪模型,而是修正提示,这才是真正的 AI 工程。

vii. Token、成本和上下文

大多数 AI 初学者在这里会看到第一笔账单,模型按 token 收费,有硬性上下文限制。如果你不明白:

- 提示词有多长

- 回复的长度有多长

- 对话历史如何增长

应用要么会失败,要么会变得昂贵。所以必须设计简洁、结构化且可重复使用的提示。

推荐免费教学资源:

OpenAI 使用与成本指南 https://platform.openai.com/docs/guides/realtime-costs

OpenAI 分词器 https://platform.openai.com/tokenizer

练习内容:

- 测量令牌计数

- 修剪提示

- 总结对话历史

这将帮助你学会保持生产系统廉价/稳定的艺术。

viii. 第一个实践项目

一旦掌握了 Python + Git + ML/LLM 基础 ,应该先做一个入门的 AI 工程项目,这里有一个简单却强大的 AI 入门项目创意:

初级 AI 项目:用 CLI 构建 LLM API 包装器

目标: 创建一个小型 Python 工具,可以:

- 接收用户文本输入

- 调用 LLM API

- 写入结构化 JSON 输出

- 处理错误和速率限制

- 记录结果日志

你将学会:

- API 请求 + 认证

- JSON 解析

- CLI 用户体验

- 日志记录与错误处理

- Git 项目结构

你可以使用:FastAPI 或 Streamlit。这个 AI 项目证明了你可以:

- 集成 LLM

- 控制输出

- 运行一个 AI 系统

成为 AI 工程师的第一阶段不是学很多概念,而是建立自信和流利度。后续阶段将假设你可以:

- 独立阅读文档

- 调试故障

- 用干净的代码构建真实的 AI 项目

这已经让你领先于大多数学习 AI 的人。到目前为止,你一直在调用模型。接下来你将开始运行系统,包括 RAG、代理、工具调用、编排。

第二阶段:RAG 系统构建(第3-4个月)

目标:学习构建基于私有数据进行检索的 LLM 系统

通用 LLM 很强大,但在企业环境中,上下文就是一切——这就是 RAG 发挥作用的地方。

i. 为什么RAG很重要

我合作过的每家公司都需要他们的 LLM 能够:

- 回答关于内部文档的问题

- 引用特定的政策或程序

- 处理专有数据

- 基于事实信息确保准确

检索增强生成(Retrieval-Augmented Generation, RAG)就是实现这一目标的方法。

ii. 核心RAG概念

文档处理:

分块策略:

- 固定大小分块(简单但粗糙)

- 基于句子的分块(保持意义)

- 基于段落的分块(保持上下文)

- 语义分块(在主题边界处分割)

对于法律合同,使用基于章节的分块来尊重文档结构。对于技术文档,语义分块效果更好。

**关键问题:**你如何在分块之间保持上下文?关于"A方义务"的条款在不知道A方是谁的情况下毫无意义。

嵌入和向量数据库:

**什么是嵌入?**文本的数值表示,捕捉语义含义。相似的概念具有相似的嵌入。

你应该了解的向量数据库:

**相似性搜索:**找到与查询语义相似的文档,即使它们不共享完全相同的关键词。

iii. 检索策略

**这里变得有趣了:**大多数候选人只知道基本的向量搜索。那些脱颖而出的人理解混合方法。

向量搜索:

- 找到语义相似的内容

- 适合同义词和意译

- 可能错过精确的关键词匹配

BM25(关键词搜索):

- 基于词频的传统搜索

- 适合精确匹配

- 错过语义相似性

混合搜索:

- 结合两种方法

- 使用重排序选择最佳结果

- 通常优于任何单一方法

何时使用什么:

- 当文档包含精确关键词但上下文错误时,向量搜索会失败

- 当同义词和意译重要时,BM25 会失败

- 带重排序模型的混合搜索通常优于任何单一方法

iv. 构建 RAG 系统

实践项目:特定领域问答系统

构建一个关于特定领域回答问题的对话AI:

- 技术文档

- 公司政策

- 研究论文

- 产品信息

要求:

- 文档处理流水线

- 用于存储的向量数据库

- 检索机制

- 用于生成的 LLM 集成

- 基本评估指标

**关键学习:**不要只是让它工作,要理解为什么工作。用检索失败的查询进行测试,记录什么会出问题以及为什么。

v. 评估的重要性

大多数候选人构建 RAG 系统但从不正确评估。这在面试中是一个危险信号。

应该跟踪的指标:

对于检索:

- Precision@K:在前K个检索到的文档中,有多少是相关的?

- 召回率:你是否找到了相关文档?

- MRR(平均倒数排名):相关结果出现的速度有多快?

对于生成:

- 忠实性:响应是否基于检索到的文档?

- 答案相关性:它是否真正解决了查询?

- 上下文精度:你是否使用了正确的分块?

生产现实:

- 延迟:用户不会等待 10s

- token 使用:直接影响预算

- 用户反馈:最终标准

vi. 免费学习 RAG 的参考资源

LangChain RAG 文档 https://python.langchain.com/docs/use_cases/question_answering/

OpenAI 检索指南 https://platform.openai.com/docs/guides/retrieval

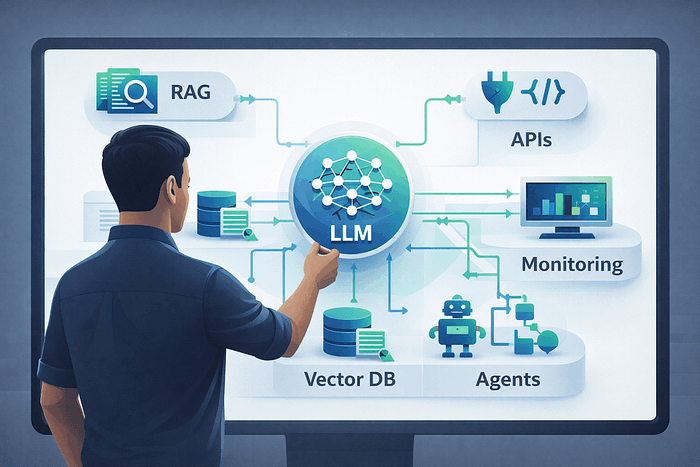

v. 智能体

聊天机器人回答问题,智能体采取行动。代理读取输入,决定行动,调用工具,评估结果,并决定下一步。这意味着它可以查询数据库、调用 API、更新记录并触发工作流。这就是 AI 从支持机器人转变为业务操作员的方式。

一旦给模型工具,就需要权限、日志记录、重试和安全检查,这就是 AI 工程。

了解智能体 AI 框架

LangChain 代理 https://python.langchain.com/docs/modules/agents/

OpenAI 工具调用 https://platform.openai.com/docs/guides/function-calling

CrewAI 开源代理框架 https://docs.crewai.com/

练习内容:

- 创建调用 API 的工具

- 让模型选择工具

- 链接每一步动作

- 记录每一步

作为一名 AI 工程师,学习这些知识将帮助你理解如何自动化实际工作。

vi. 编排:真正的 AI 技能

真正的 AI 系统不是单一的提示,而是流水线,单个用户请求可能涉及分类、检索、推理、工具调用、验证和响应格式化。像 LangChain、Langgraph 和 Autogen 这样的框架存在,是因为没人愿意每次都硬编码这些逻辑。但了解框架并不是唯一目标,需要理解编排存在的原因。

练习内容:

- 分类用户意图

- 通往不同流水线的路由

- 结合 RAG、代理和验证

这就是你开始理解 AI 如何成为基础设施的地方。

第三阶段:生产工程(第5-6个月)

目标:学习在生产环境中部署和维护 LLM 系统所需的知识

公司期望候选人部署模型,而不仅仅是在笔记本中进行构建。

**现实检查:**这是大多数候选人面试失败的地方。他们可以构建演示,但没有考虑生产环境。

i. API 设计

LLM 应用需要可访问,意味着需要构建适当的 API。

必备项:

- REST 或 GraphQL 端点

- 身份验证和授权

- 速率限制(防止滥用)

- 请求验证

- 错误处理和重试

- 超时管理

示例结构:

@app.post("/chat")

async def chat_endpoint(

request: ChatRequest,

user: User = Depends(get_current_user)

):

try:

# 速率限制检查

await check_rate_limit(user.id)

# 验证输入

validate_message(request.message)

# 带超时调用LLM

response = await call_llm_with_timeout(

request.message,

timeout=30

)

return ChatResponse(

message=response,

tokens_used=count_tokens(response)

)

except RateLimitError:

raise HTTPException(429, "Rate limit exceeded")

except TimeoutError:

raise HTTPException(504, "Request timeout")

except Exception as e:

log_error(e)

raise HTTPException(500, "Internal error")

ii. 监控和可观察性

应该监控什么:

性能指标:

- 延迟(P50、P95、P99 —— 不仅仅是平均值)

- 每个请求的 token 使用量

- 吞吐量(每秒请求数)

质量指标:

- 响应忠实性和答案相关性

- 幻觉率

- 用户满意度分数

成本指标:

- 总 token 消耗

- 每次用户交互的成本

- 缓存命中率

安全指标:

- 提示/响应中的 PII 检测

- 提示注入尝试

- 恶意输入模式

LLM 可观察性提供端到端追踪,对每个步骤的输入、输出、延迟、token 使用和错误具有可见性。

需要学习的工具:

- LangSmith 用于 LLM 可观察性

- Weights & Biases 用于实验跟踪

- 自定义日志记录和指标仪表板

iii. 提示词版本控制

将提示词视为代码。

提示词版本控制系统应该包括:

- 版本控制(Git)

- 变更的 A/B 测试

- 每个版本的指标跟踪

- 回滚能力

- 变更原因的文档

**为什么这很重要:**你向生产环境推送了一个新提示,突然用户满意度下降了15%,能否识别是什么造成变化?能否快速回滚?

没有版本控制,就是在盲目修改。

iv. 成本优化

在生产环境中,token 使用量会快速累积。

管理成本的策略:

缓存:

- 缓存常见查询

- 尽可能重用嵌入

- 对相似查询使用语义缓存

提示词优化:

- 移除不必要的冗长

- 使用更短、更清晰的指令

- 测试更少的示例是否同样有效

模型选择:

- 尽可能使用较小的模型

- 为复杂查询保留昂贵的模型

- 实现回退链(首先尝试便宜模型)

Token 管理:

- 设置适当的 max_tokens

- 智能截断上下文

- 监控并在使用量激增时发出警报

v. 生产项目

构建并部署一个具有完整生产设置的 RAG 系统:

要求:

- 带身份验证的适当 API

- 监控仪表板

- 提示版本控制系统

- 错误处理和日志记录

- 成本跟踪

- A/B 测试能力

- 部署到云(AWS、GCP 或 Azure)

**成功指标:**能否解释每个生产决策?为什么选择那个数据库?为什么选择那个缓存策略?为什么选择那些监控指标?

第四阶段:高级专业化(第7-8个月)

目标:通过在一个领域的深度专业知识脱颖而出

此时,你已经掌握了基础知识。现在通过专业化来让自己与众不同。

i. 选择你的路径

路径A:智能体 AI

你将学习:

- 多智能体系统

- 工具使用和函数调用

- 能够独立思考和行动的自主系统

- 智能体内存和状态管理

**为什么重要:**智能体AI系统采用专门的智能体——路由智能体将查询定向到专门的智能体,协调智能体管理复杂工作流程,工具智能体执行具体操作。

项目:构建一个多智能体自动化系统

路径B:LLMOps

你将学习:

- LLM 系统的 CI/CD 管道

- 自动化模型评估和回滚

- 大规模提示管理

- 性能调优和成本优化

**为什么重要:**随着 LLM 系统变得越来越关键,确保它们的可靠性、性能和成本效益成为一项专业技能。

项目:构建一个完整的 LLMOps 平台

ii. 高级技能掌握

函数调用和工具使用:

- 为LLM定义自定义函数

- 处理函数调用错误和回退

- 构建可以与外部系统交互的智能体

记忆管理:

- 短期记忆(对话上下文)

- 长期记忆(用户偏好和历史)

- 向量记忆和检索

高级RAG技术:

- 知识图谱集成

- 层次化检索

- 自我修正RAG

iii. 系统架构

真正的AI工程师需要理解整体系统架构:

可扩展性模式:

- 水平扩展LLM服务

- 负载均衡和故障转移

- 数据分区和分片策略

安全考虑:

- 数据加密和隐私保护

- 提示注入防护

- 访问控制和审计

集成模式:

- 微服务架构中的LLM

- 事件驱动的AI系统

- 传统应用的AI集成

iv. 职业发展策略

建立你的个人品牌:

- 在 GitHub 上发布项目

- 写技术博客

- 参与开源项目

- 在技术会议上演讲

求职准备:

- 准备一个作品集项目

- 练习系统设计面试

- 建立技术人脉网络

- 了解市场薪酬水平

持续学习:

- 关注 AI 研究进展

- 参加在线课程和研讨会

- 加入专业社区

- 寻找导师指导

技能组合:

- 扎实的软件工程基础

- 深度的LLM专业知识

- 生产环境经验

- 系统架构能力

- 业务理解能力

v. 作品集示例

1. 企业 RAG 决策系统

公司有成千上万份文件,但员工无法快速找到正确的答案来做出决策。支持、法务和合规团队浪费数小时搜索 PDF 和内部 wiki。错误或过时的信息会导致真正的财务和法律风险。

这个 AI 项目说明你可以将非结构化公司数据转化为可用的 AI 系统,证明你理解检索、准确性和可解释性,而这些正是企业所重视的。现在每家大型公司都在内部努力建立这个项目。

参考源代码

langchain-ai/rag-from-scratch:展示 RAG 基础知识的笔记本,用 LangChain 进行索引、检索和生成。GitHub:https://github.com/langchain-ai/rag-from-scratch

adshyam/RAG-Chatbots-with-Langchain-and-Pinecone:使用 Pinecone 作为矢量数据库,搭配 LangChain 和 OpenAI 的 RAG 聊天机器人。GitHub:https://github.com/adshyam/RAG-Chatbots-with-Langchain-and-Pinecone-Vector-DB

pinecone-io/genqa-rag-demo:RAG 生成问答示例,使用 Pinecone + LangChain + OpenAI。GitHub:https://github.com/pinecone-io/genqa-rag-demo

AnilDeshpande/YouTubeLocalRAG:基于 Python 的 RAG 系统,用于查询本地文本数据。GitHub:https://github.com/AnilDeshpande/YouTubeLocalRAG

2. 自然语言到 SQL 分析系统

业务团队只能等分析师去查询数据,决策进展缓慢,洞察被 SQL 和 BI 工具困住了。而领导现在就需要答案,而不是等仪表盘更新。

这个 AI 项目说明你可以将 AI 与真实商业数据连接起来,而不仅仅是文本。证明你懂得模式推理、数据安全和分析工作流程。这样就能向招聘经理证明,你能打造一个成为决策引擎而不仅仅是聊天机器人的 AI 系统。

参考源代码

虽然目前还没有太多开源仓库示例,但 Bedrock agent text2sql 展示了一个真实可部署的 LLM 代理文本转 SQL 集成示例:https://github.com/build-on-aws/bedrock-agent-txt2sql

3. AI 工作流编排器

团队在手动转发邮件、工单和请求上浪费时间。重要问题会丢失、延迟或处理不一致。规模化运营通常意味着雇佣更多人,而不是自动化工作。

这个 AI 项目证明你能打造一个能采取行动的 AI,而不仅仅是给出答案。它展示了真实世界的编排、工具调用和系统可靠性。这正是公司愿意花大价钱购买的系统类型。

参考源代码

500+ AI 代理项目/用例,可以找到许多示例学习构建,包含数十种实用代理模式:https://github.com/ashishpatel26/500-AI-Agents-Projects

vi. 认证

认证有助于自动筛查,招聘经理认可的几个例子:

IBM AI 工程专业证书

Azure AI Engineer

Databricks 生成式人工智能工程师

AWS 认证 AI 从业者

证书不能替代项目,但能帮助你的简历被看见,为简历锦上添花。

结论:你的 AI 工程师之路

成为高薪 AI 工程师不能一蹴而就,但是一个非常可实现的目标。关键是要:

- 建立坚实的基础:不要跳过基础知识

- 专注于实际应用:构建真实的项目,而不仅仅是教程

- 考虑生产环境:从第一天起就思考可扩展性、可靠性和成本

- 持续学习:AI 领域发展迅速,保持更新至关重要

- 建立网络:与其他 AI 工程师建立联系,寻找导师

这个领域才刚刚开始爆发性增长。现在开始学习这个技能组合,将在未来十年内处于非常有利的位置。

记住,AI 工程不是关于知道每个工具,而是关于构建不会被破坏的系统。如果你已经了解软件工程,就不是从零开始,而是在扩展技能组合。

专注于基础、动手构建、理解权衡。持续这样做 6-12 个月,就将领先于大多数试图进入 AI 领域的人。